極致效能、成本效率與全開放資源生態

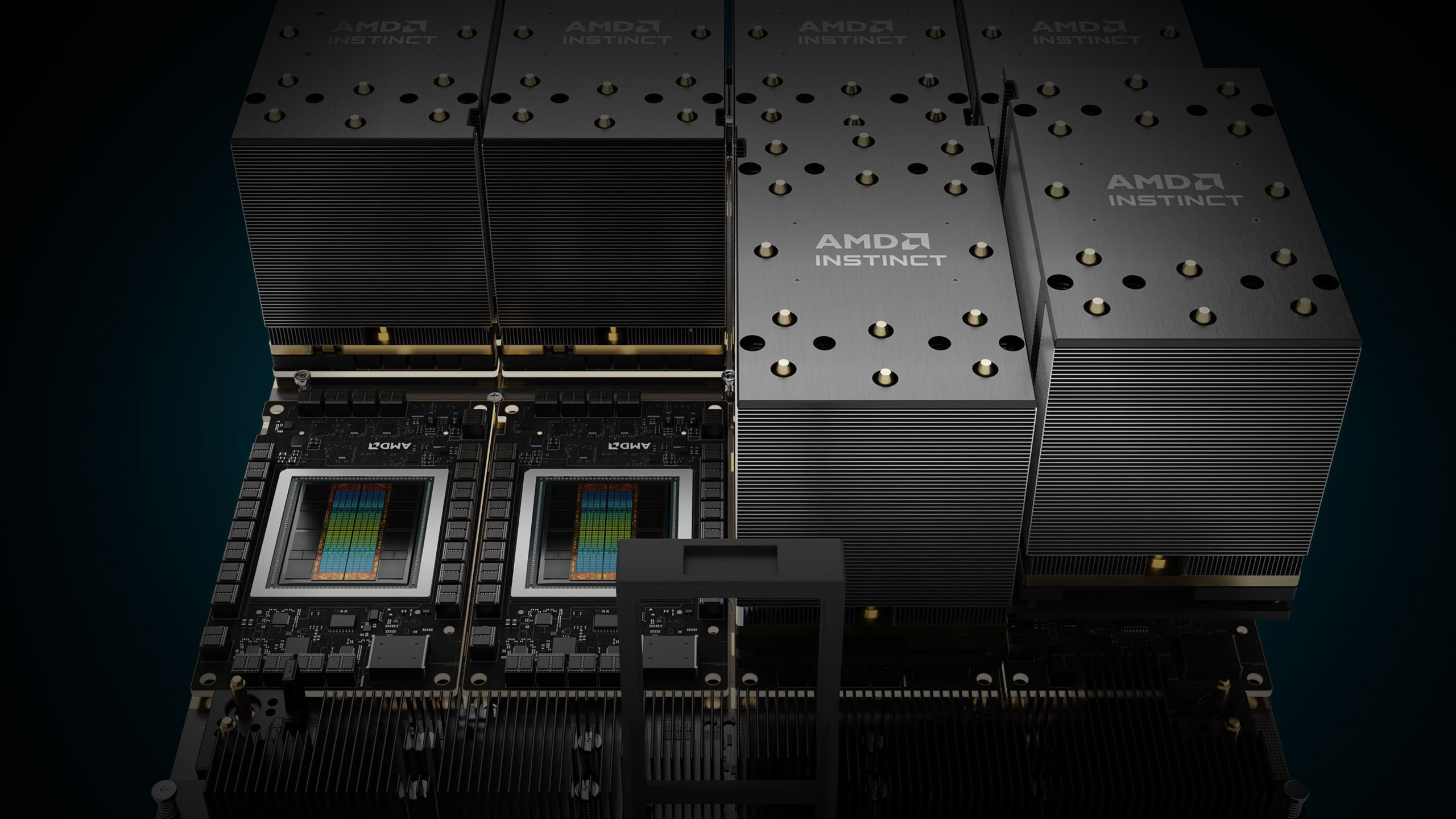

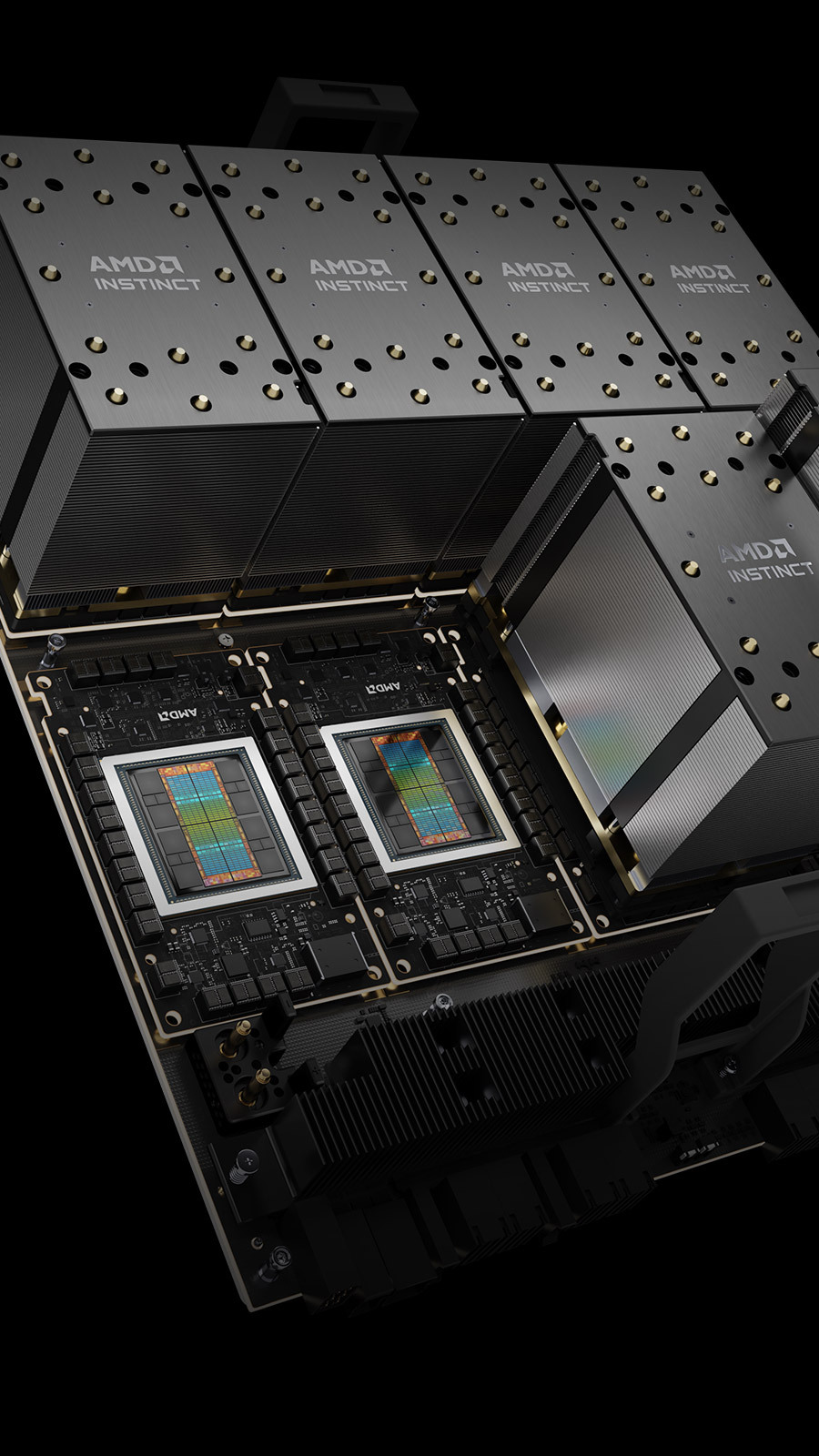

AMD Instinct™ MI350 系列

AMD 於 2025 年 6 月正式推出 AMD Instinct™ MI350 系列 GPU,為資料中心運算帶來重大躍進,專為生成式 AI 與高效能運算工作負載而設計。此系列採用先進的第 4 代 AMD CDNA™ 架構,並以台積電 3 奈米製程打造,提供卓越的效能與能源效率,能以高速完成大型 AI 模型訓練、高速推論以及複雜的 HPC 工作負載,如科學模擬與資料處理。MI350X 與 MI355X GPU 皆配備 288GB HBM3E 記憶體、高達 8TB/s 的頻寬,在 AI 運算效能上較前一代提升最高 4 倍,推論效能更達 35 倍的突破,奠定其在 AI 與 HPC 市場中強大的競爭地位。

AMD Instinct | |||

|---|---|---|---|

MI355X GPU | MI350X GPU | 型號 | MI325X GPU |

| TSMC N3P / TSMC N6 | 製程技術 (XCD / IOD) | TSMC N5 / TSMC N6 | |

| AMD CDNA4 | GPU 架構 | AMD CDNA3 | |

| 256 | GPU 運算單元 | 304 | |

| 16,384 | 串流處理器 | 19,456 | |

| 1,850 億 | 電晶體數 | 1,530 億 | |

| 10.1 PFLOPS | 9.2 PFLOPS | MXFP4 / MXFP6 | N/A |

| 5.0 / 10.1 POPS | 4.6 / 9.2 POPS | INT8 / INT8 (稀疏性) | 2.6 / 5.2 POPS |

| 78.6 TFLOPS | 72.1 TFLOPS | FP64 (向量) | 81.7 TFLOPS |

| 5.0 / 10.1 PFLOPS | 4.6 / 9.2 PFLOPS | FP8 / OCP-FP8 (稀疏性) | 2.6 / 5.2 PFLOPS |

| 2.5 / 5.0 PFLOPS | 2.3 / 4.6 PFLOPS | BF16 / BF16 (稀疏性) | 1.3 / 2.6 PFLOPS |

| 288 GB HBM3E | 專用記憶體大小 | 256 GB HBM3E | |

| 8 TB/s | 記憶體頻寬 | 6 TB/s | |

| PCIe Gen5 x16 | 匯流排類型 | PCIe Gen5 x16 | |

被動式 & 液冷 | 被動式 | 散熱 | 被動式 & 液冷 |

| 1400W | 1000W | 主機板功耗 | 1000W |

支援最多 8 個分區 | 虛擬化支援 | 支援最多 8 個分區 | |

AMD Instinct™ MI300 系列

概覽規格

百萬兆次運算時代的加速核心

- 專為最嚴苛工作負載打造的 AMD Instinct™ MI325X GPU,具備 256GB 記憶體與每秒 6 TB 頻寬,結合卓越效能與高能源效率,並支援矩陣稀疏運算(Matrix Sparsity),以最佳化 AI 訓練與推論效能。

- 全球首款資料中心級整合加速處理單元(APU),AMD Instinct™ MI300A,突破 CPU 與 GPU 之間的效能瓶頸,消除程式設計負擔並簡化資料管理流程。

- 由 AMD EPYC™ 處理器與 AMD Instinct™ GPU 與 APU 驅動的全球最快超級電腦 El Capitan 與 Frontier,不僅在 TOP500 榜單名列前茅,同時於 GREEN500 榜上展現傑出的能源效率,充分展現 AMD 在高效能運算與 AI 加速領域的領導地位。

技嘉科技為百萬兆次運算時代推出先進伺服器方案,將 AMD Instinct™ MI325X 與 MI300X GPU 以開放加速模組(OAM)型式安裝於通用基板(UBB),搭載於 GIGABYTE G 系列伺服器中。整合 CPU 與 GPU 的 AMD Instinct™ MI300A APU 則配置於 GIGABYTE G383 系列,支援四組 LGA 插槽設計。此系列系統兼具高運算密度、卓越擴充性與冷卻效率,協助企業與研究機構推進 AI 與 HPC 的創新發展。

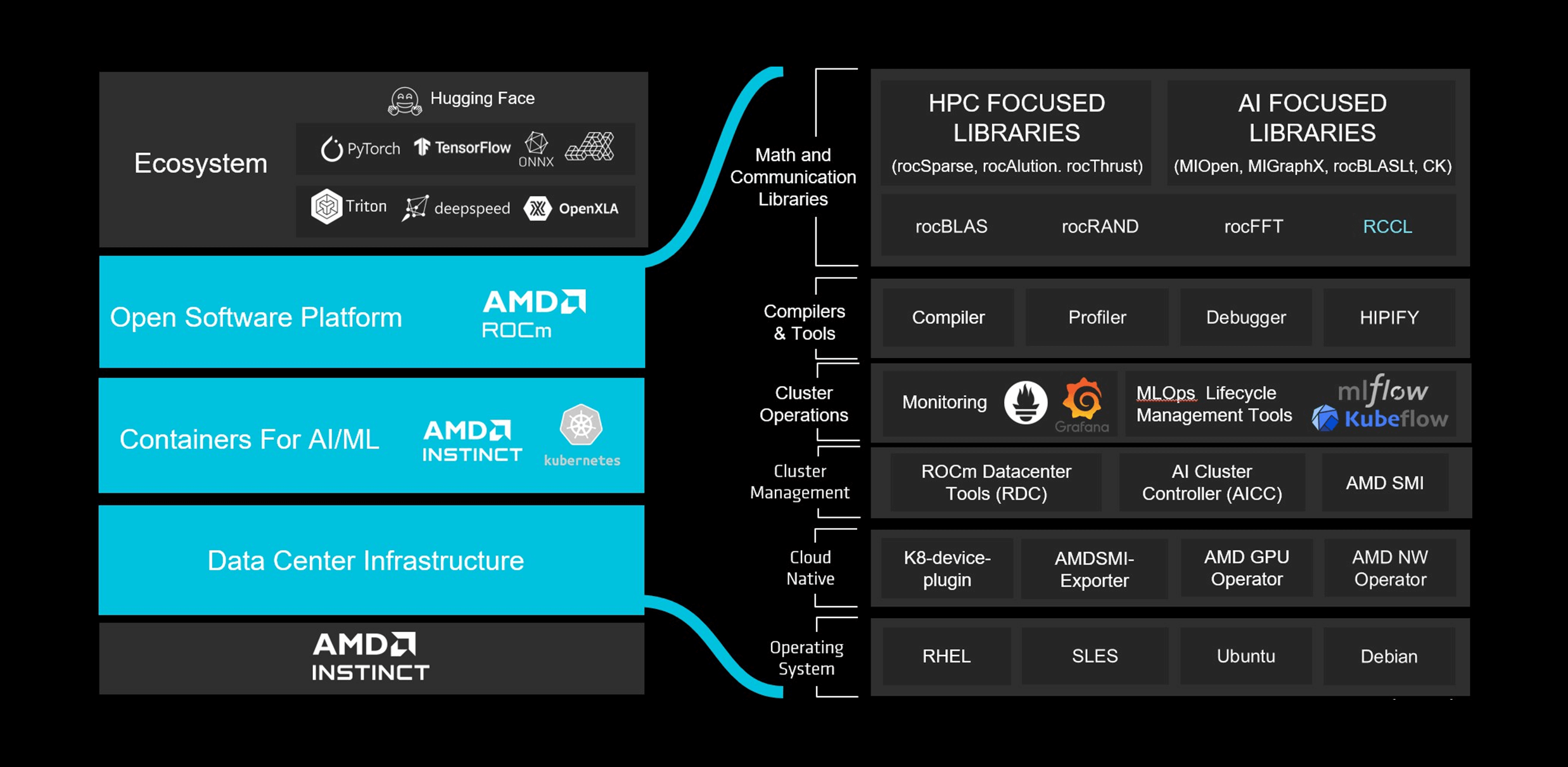

以 AMD ROCm™ 7.0 開創新世代極致效能

| AMD ROCm™ 7.0 軟體堆疊是讓 AMD Instinct™ MI350 系列發揮極致效能的關鍵差異化技術。開發者能在幾乎不需修改程式碼的情況下,進行高效能 AI 與 HPC 應用開發。MI350 系列 GPU 已針對主流框架如 PyTorch、TensorFlow、JAX、ONNX Runtime、Triton、vLLM 進行全面最佳化,並透過自動核心生成與持續驗證,提供零時差的模型支援。 | |

|---|---|

|

|

| [1] (MI300-080)AMD 於 2025 年 5 月 15 日進行測試,測量 ROCm 6.x(搭配 vLLM 0.3.3)與 ROCm 7.0 預覽版(搭配 vLLM 0.8.5)在推論效能上的差異。測試環境採用 8 組 AMD Instinct MI300X GPU,運行 Llama 3.1-70B(TP2)、Qwen 72B(TP2)及 Deepseek-R1(FP16)等模型,批次大小介於 1 至 256 、序列長度為 128 至 204 。所述效能提升以三個 LLM 模型的平均每秒字元處理數(Tokens Per Second, TPS)計算。實際結果可能因系統設定與工作負載而異。 | |

選擇搭載 AMD Instinct™ 伺服器

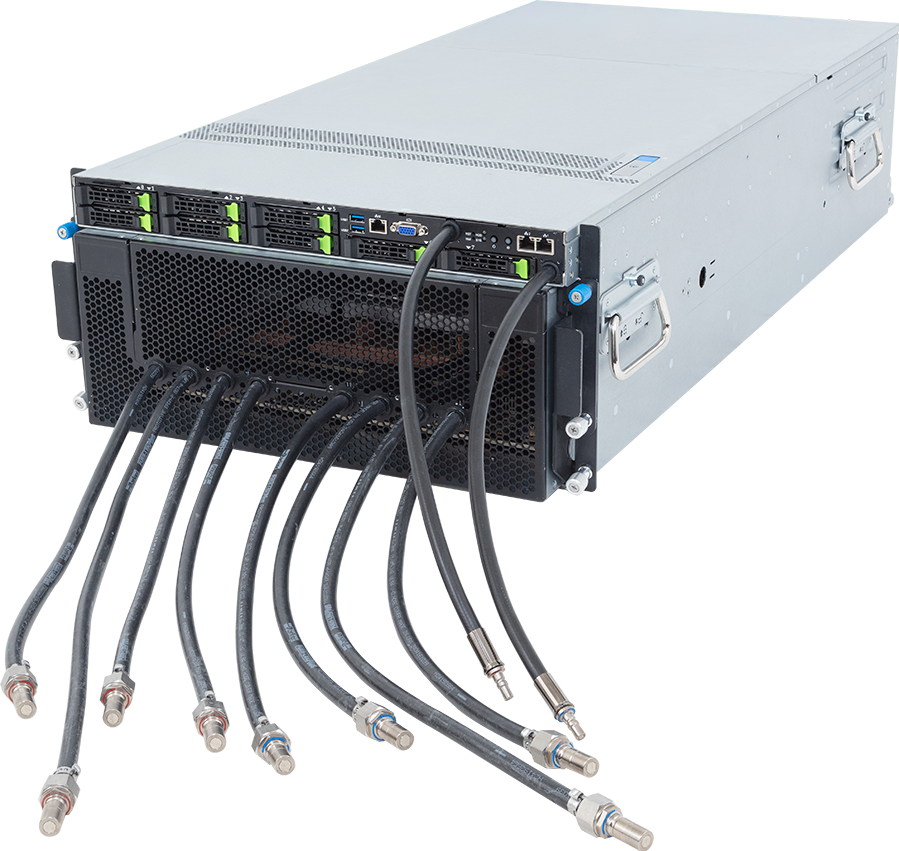

高密度算力

提供業界領先的高密度算力,8U 機身的氣冷 G893 系列及 4U 機身的液冷 G4L3 系列,擁有高密度算力同時亦提供絕佳穩定性。

高效能運算

搭載 8 組 GPU 模組基板的伺服器透過優化的散熱設計,確保處理器和 GPU 算力維持峰值效能。

彈性擴展

提供多組擴充槽,可彈性配置乙太網路或 InfiniBand 網路介面卡,以實現節點之間高速資料傳輸。

先進散熱

隨著導入直接液冷(DLC)技術,改善系統整體表現,處理器與 GPU 的熱設計功耗(TDP)持續增長也不構成問題,充分發揮尖端運算的最大潛能。

能源效率

透過即時電源管理、自動風扇速度控制以及冗餘鈦金級電源供應器(PSU)確保最佳的散熱效果和能源效率。亦有液冷方案供選擇。