CoolIT液體冷卻運算系統

技嘉科技與CoolIT Systems聯手合作,為HPC(高性能運算)、AI(人工智慧)和雲端服務的各式應用與系統挑戰,提供靈活、成熟和可靠的液體冷卻解決方案。

Email Sales

應用領域介紹

技嘉科技與直接液體冷卻技術領導廠商CoolIT Systems合作,提供電腦機房安裝高密度運算架構之液體冷卻架構解決方案。具備隨插即用的便利性,可整合外部液體-氣體或液體-液體冷卻系統,幫助客戶端更有效管理持續增加熱負荷的資料中心硬體環境。

成功案例實績

德國航空航天中心(DLR) HPC高可用運算集群

GIGABYTE、CoolIT和NEC三家公司共同合作,提供直接液體冷卻(DLC)部署到德國國家航空航天中心HPC高可用運算集群,供航空、航天和交通領域的研究開發。整體HPC高可用運算集群採用技嘉的 H261-Z60,包含2,300台技嘉主機運算節點,內裝載AMD EPYC™ 7601 處理器,提供高達147,200內核(Core)的運算能力,在35°C 的常溫水進水口條件下,進行直接液體冷卻(DLC)架構。整體直接液體冷卻(DLC)冷卻系統解決高效元件所需要的散熱結構,為所產出熱量提供循環再利用條件。

相關文章: https://www.gigabyte.com/tw/Article/how-does-gigabyte-hci-server-propel-aerospace-center-researches

雲端運算服務、高性能集群運算(HPC)的冷卻挑戰

隨著雲端趨勢的快速發展以及對人工智能 (AI)、高性能運算 (HPC) 和物聯網(IoT)的服務與產品需求不斷推陳出新,全球各大型資料中心也在持續擴充機房佔地規模。

另外資料中心在侷限的機房空間條件下,對更高運算能力也在增加需求,因此選用來自英特爾、AMD和NVIDIA更強大的新世代元件。這些新世代與高密度伺服器主機,極度需要將大量高溫從內部經由熱交換傳導到外部的高效冷卻解決方案。但在昂貴的土地建築成本與需求時間的拉扯下,使得資料中心只能選擇提高既有機房內運算主機密度。此時因為高密度運算主機更緊密地排列,既有機房環境與機櫃中氣流空間更小,造成更多的熱負荷冷卻問題。倘若貿然增加大量冷卻風扇會引起振動、噪音、耗能,容易導致伺服器內相關組件損壞機率;整個機房環境造成現場維護人員對噪音與環溫...等工作負荷將更嚴苛。

據估計,現代化資料中心消耗了全球約2% 以上的電力,總體大約2720億千瓦。這些供電能源消耗有大部分不是用在運算主機,而是用於資料中心機房冷卻空調設備。資料中心目前採用的傳統氣體冷卻效率比較低,因為機房環境溫度控制每年所產生熱量超過 400萬億BTU單位,於現代碳稅計算,屬於超大碳足跡費用等級。

將液體與空氣對比,液體冷卻能更有效的將熱量從伺服主機元件引導降溫的方式,因此所需的耗能更少。因為解熱技術結構不同,資料中心內部不需要大型風扇和冰水機等空氣冷卻設備,液體冷卻系統可以在電腦機櫃支持更高密度伺服器主機與更高效能的CPU和 GPU元件,從而提高資料中心機房的空間利用率,降低總擁有成本。

直接液體冷卻(DLC)技術成熟且標準化,已經是現今資料中心和中/小型HPC高效能叢集的最佳部署選擇。

解決方案:整合CoolIT DLC的技嘉科技高密度伺服器

技嘉科技與CoolIT直接液體冷卻(DLC)技術領導商合作,全新設計H262系列高密度服務器系統,將直接液體冷卻(DLC)系統作為標準配置,從而簡化客戶端驗證評估程序。

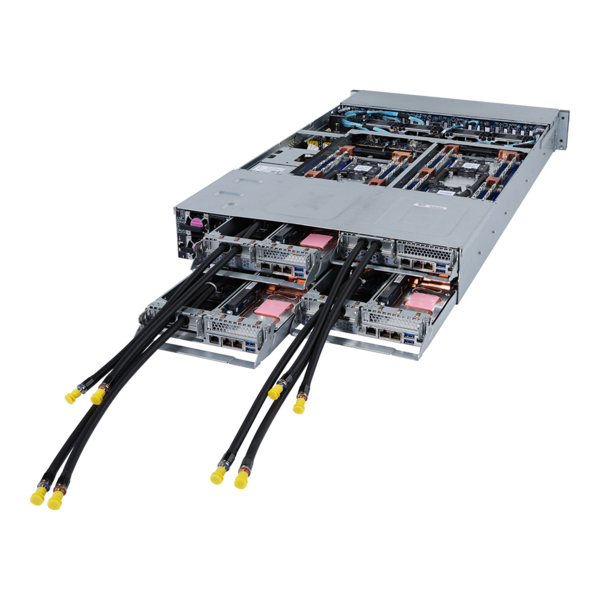

H262系列高密度、高運算效能機型

技嘉科技H262系列 (支援AMD EPYC 7002/7003)兼具超高密度與強大運算兩項優點的伺服器設計,驗證整合CoolIT直接液體冷卻(DLC)技術,供給客戶端最大高性能。在2U機身高度裝載四台雙CPU運算節點,支援AMD EPYC 7002/7003單顆最高提供64核心128 線程高效能處理器,整台H262系列伺服器最高提供512核1024線程的運算能力,記憶體提供64插槽(16 x 4 = 64 Slots)最高支援3200MHz時脈,以及24顆2.5吋Gen4 GEN4 U.2 硬碟熱插拔基座。H262系列優越效能與解熱能力,一舉解決傳統風冷架構無法達到高效元件配置佈署問題。

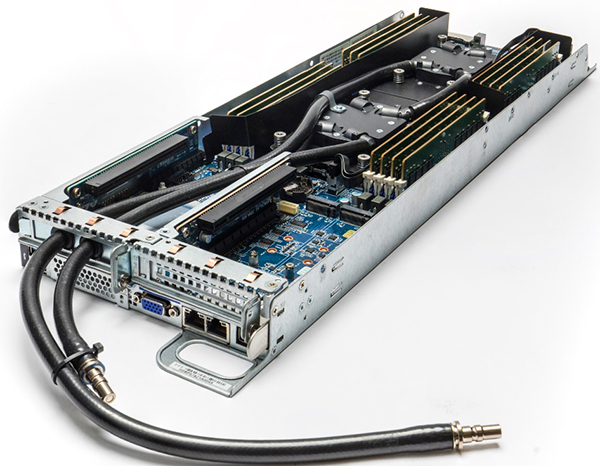

具備DLC液體冷循環板-單一運算節點圖示

直接液體冷循環-標準化模組

CoolIT直接液體冷卻(DLC)平台採標準化模組設計,整合電腦機櫃與運算主機整體直接液體冷卻(DLC)解決方案,提高機櫃主機密度、組件性能和電源效率。CoolIT Systems亦嚴格遵守資料中心安全規範並符合 UL 62368-1資料中心設備認證的新安全標準,提供高可靠性、高性能和低壓降等優勢。

直接液體冷卻(DLC)系統可運用常溫進水,採密閉式液冷設計。它使用被動式水冷循環板(Passive Cold Plate Loops)和分歧管(Rack Manifold)將所有熱量帶出機櫃,利用CDU(Cooling Distribution Unit) 提供循環動力,使CDU二次側輸出的溫水直接在主機外進行熱交換。主機內經由液冷組件將大功率組件,如CPU、GPU、Memory、High-speed network card等發熱元件熱量帶走。

直接液體冷卻(DLC)對比CRAC(Computer Room Air Conditioning)技術結構。當客戶採用直接液體冷卻(DLC)系統,可將原有機房內大部分CRAC致冷裝置或專用冰水機拆除,直接降低資本支出(CAPEX)。

技嘉科技製造設計H262系列高密度主機,協助客戶的資料中心可在高密度IT部署獲得大幅削減TCO、降低能耗和噪音、提高系統性能的最佳效益。

CoolIT直接液體冷卻(DLC) -標準化模組

CoolIT直接液體冷卻(DLC)系統三大標準模組:

1.被動式水冷循環板

技嘉科技出廠時即安裝在伺服器的處理器、記憶體、網卡等元件上替換原有的氣冷式散熱鰭片。出廠交貨前即裝好CoolIT的被動式液冷循環板,確保冷水板單向逆止閥泵送裝置的安全性與降低客戶安裝錯誤之故障機率。

技嘉科技出廠時即安裝在伺服器的處理器、記憶體、網卡等元件上替換原有的氣冷式散熱鰭片。出廠交貨前即裝好CoolIT的被動式液冷循環板,確保冷水板單向逆止閥泵送裝置的安全性與降低客戶安裝錯誤之故障機率。

被動式水冷循環板

2.主機機架冷熱水通道分歧管

CoolIT 機架式分歧管設計適用各式電腦機架,每個液冷伺服器主機運算節點經冷熱水通道歧管連接到電腦機架的CDU(冷卻液分配單元)。材質選用高級不銹鋼金屬的快速斷開/連接接頭,使得IT設備維護人員可快速維護任何單一節點伺服器。冷熱水通道分歧管採顏色編碼,紅色(熱)和藍色(冷),讓維護人員可視覺化正確銜接冷熱水通道分歧管接頭到水冷循環板。CoolIT的冷熱水通道歧管安裝簡易,在電腦機架中僅需要一個機櫃電源排插(PDU)空間。還可以接受客製化訂製,藉以配合不同款式機架與主機連接數量。

CoolIT 機架式分歧管設計適用各式電腦機架,每個液冷伺服器主機運算節點經冷熱水通道歧管連接到電腦機架的CDU(冷卻液分配單元)。材質選用高級不銹鋼金屬的快速斷開/連接接頭,使得IT設備維護人員可快速維護任何單一節點伺服器。冷熱水通道分歧管採顏色編碼,紅色(熱)和藍色(冷),讓維護人員可視覺化正確銜接冷熱水通道分歧管接頭到水冷循環板。CoolIT的冷熱水通道歧管安裝簡易,在電腦機架中僅需要一個機櫃電源排插(PDU)空間。還可以接受客製化訂製,藉以配合不同款式機架與主機連接數量。

機架冷熱水通道分歧管

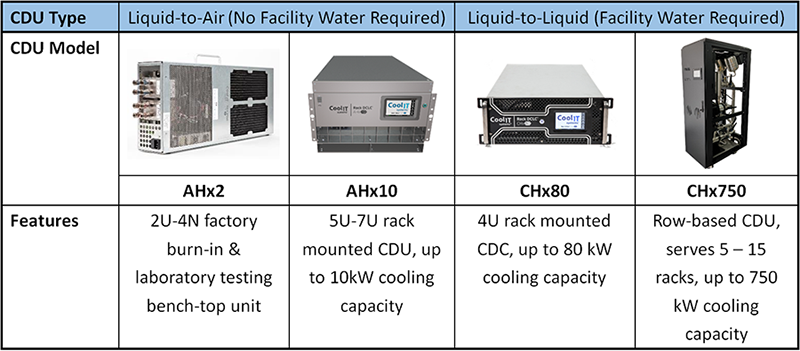

3. 冷卻液分配裝置 (CDU:Coolant Distribution Unit)

CoolIT的CDU連接到機架冷熱水通道分歧管,可用於液對氣(適用於銜接傳統氣冷空調環境的資料中心)或液對液設計(適用於具有液冷基礎設施的資料中心)。冷卻液分配裝置 (CDU)主要作為智能環境溫度控制系統,用於管理CoolIT直接液體冷卻(DLC)系統中所有伺服器主機的入水溫度和入水流量。CDU區分機櫃內部(例如CHx80)與整櫃外部(例如CHx750)兩大類型產品,均可輕鬆安裝在機房內部,經由冷熱水通道分歧管輕鬆連接與斷開單一個別伺服主機。

CoolIT的CDU連接到機架冷熱水通道分歧管,可用於液對氣(適用於銜接傳統氣冷空調環境的資料中心)或液對液設計(適用於具有液冷基礎設施的資料中心)。冷卻液分配裝置 (CDU)主要作為智能環境溫度控制系統,用於管理CoolIT直接液體冷卻(DLC)系統中所有伺服器主機的入水溫度和入水流量。CDU區分機櫃內部(例如CHx80)與整櫃外部(例如CHx750)兩大類型產品,均可輕鬆安裝在機房內部,經由冷熱水通道分歧管輕鬆連接與斷開單一個別伺服主機。

冷卻液分配裝置

更好的能源使用效率

直接液體冷卻(DLC)系統使用的冷卻劑具備出色導熱性能,可將提升高效元件更高密度並穩定達成散熱冷卻效果。根據美國冷凍空調學會的報告中,關於直接液體冷卻(DLC)伺服器通用設計、組件和部屬程序白皮書(ASHRAE Technical Committee 9.9- White Paper ),證實CoolIT Systems的直接液體冷卻系統設計,完全符合ASHRAE 定義的W2(27°C)至 W5(45°C)液體解熱負荷範圍,對於傳統氣冷式資料中心的高效運算與高密度等伺服器佈署,顯著減少大量昂貴氣冷散熱裝置與散熱風扇耗電。

選用整套技嘉科技H262系列高密度伺服器與CoolIT Systems直接液體冷卻系統,即可獲得明顯降低資訊中心耗電量、碳足跡,以及更好的PUE(電源使用效率)效益。

高效能、高密度伺服器

技嘉科技全新設計H262系列高密度伺服器,已經整合CoolIT DLC架構產品,簡化客戶端佈署程序。也可應實際需求請業務窗口提供其他型號。

Related Technologies

高效能運算是什麼?

高效能運算(High Performance Computing)簡稱HPC,係指能高速處理數據或執行指令的運算能力,特別形容每秒浮點運算次數(FLOPS)超越一兆次(teraFLOPS)的作業系統。全球領先的超級電腦每秒浮點運算次數已突破一千兆(petaFLOPS),下一個里程碑將是每秒一百萬兆浮點運算次數(exaFLOPS),即所謂的「百萬兆級運算」(exascale computing)。為達成此目標,須集結大量的CPU或GPU進行平行運算。運算叢集是常見的高效能運算解決方案之一,數台電腦(或稱nodes「節點」)互相串聯成為群組,運算能力遠超過單一電腦主機,多數節點可協同解決一台電腦無法處理的問題。了解更多:《什麼是HPC高效能運算 - 技嘉科技指南》

資料中心是什麼?

資料中心 (Data Center) 是組織用來集中部署關鍵 IT 設施的專用場所,內含伺服器、儲存裝置、網路設備 (如交換機、路由器及防火牆) 及基礎設施 (機架、佈線、備用發電機、UPS 不斷電系統、冷卻與通風設備等等)。資料中心的大小從單個房間到大型綜合倉儲皆有。美國國家標準協會 (ANSI) 和電信工業協會 (TIA) 發佈了 ANSI/TIA-942 的準則「資料中心電信基礎設施標準」,根據不同級別的可靠性或彈性定義了四種層級的資料中心。

.第 1 級資料中心: 基礎設施簡單,缺乏冗餘設備,對物理事件的保護能力有限,無法在不中斷服務的情況下進行維修。.第 2 級資料中心: 具備冗餘元件,提供較佳的韌性與穩定性。.第 3 級資料中心: 可同時維護的基礎設施,允許在不中斷服務的情況下進行維修或更換,並能抵禦大多數的物理事件。.第 4 級資料中心: 具備完全容錯的基礎設施和冗餘子系統,即使關鍵元件故障也能確保連續運行,提供最高等級的安全性與保護。

液體冷卻是什麼?

顧名思義,液體冷卻(liquid cooling)是以液體作為熱能傳導機制的散熱方式。市面上常見的兩種伺服器專用液體冷卻技術,分別為直接液冷(DLC),或稱直達晶片(D2C)液冷;以及浸沒式液冷(immersion cooling),而這類別又可分為單相浸沒式液冷與兩相浸沒式液冷。若想了解關於技嘉科技的浸沒式液冷解決方案,可直接參考我們的專屬詞彙,或是前往浸沒式液冷解決方案的專屬網頁。

直接液冷幫伺服器解熱的方法,是將裝滿冷卻液的密封管線(或稱封閉式冷卻迴路)環繞在伺服器內最容易發熱的關鍵零組件附近,零組件透過導熱銅片(或稱「冷板」)將熱能傳導到冷卻液,然後,冷卻液沿著管線流出伺服器,透過熱交換器進行散熱,最終流回伺服器內繼續使用。

如果將熱交換器安裝在伺服器機櫃內,把熱能排放到空氣中,這是液冷技術中所謂的「液對氣」方案,優點在於液冷式伺服器能直接部署在氣冷式的資料中心使用。所謂的「液對液」方案,則是將冷卻液傳送到伺服器機房的液體冷卻管線,透過設施的冷卻管路與散熱機制統一排熱;強項在於解熱功力比「液對氣」方案更勝一籌,限制在於機房設計必須提供液體冷卻管線,也就是說,這必須是專為液冷伺服器所設計的特殊機房。

Resources

加速實現你的科技創新

業務洽詢