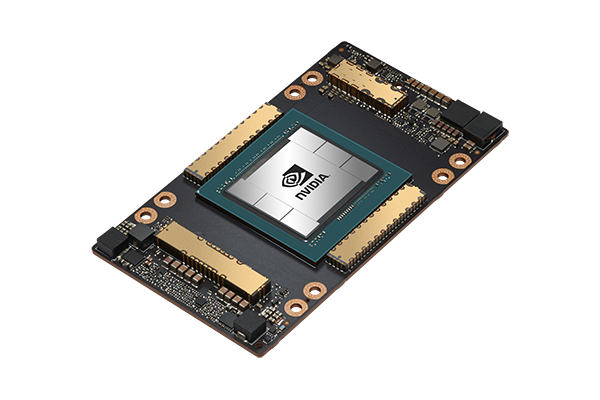

NVIDIA A100 Tensor核心GPU

支援多種運算精度兼具彈性GPU資源分配與擴展

適用於各種工作負載的超強運算平台

NVIDIA A100 Tensor核心GPU可在各種場域提供前所未有的運算加速,為人工智慧 (AI)、數據分析和高性能運算 (HPC) 應用程式的數據分析提供動力。NVIDIA A100作為資料中心平台的運算引擎,性能比上一代NVIDIA Volta™高出20倍。A100的多執行個體GPU (Multi-Instance GPU, MIG) 技術能將A100安全地切割為七個用於CUDA應用的個體,從而為多個用戶提供獨立的GPU資源以優化GPU使用率。透過MIG技術,資料中心能夠彈性動態調整以適應不斷變化的工作負載需求。

NVIDIA A100支援廣泛的精度範圍,高達80GB的GPU記憶體也比前一代記憶體增加一倍,能提供目前世界上最快的內存傳輸效率,達到每秒2TB的頻寬,從而解決大型模型和龐大資料集的分析處理能力。

NVIDIA A100同時是NVIDIA資料中心解決方案的最佳選擇。NVIDIA NGC™目錄提供不同AI應用和高性能運算的優化軟體模組,適用於搭載NVIDIA A100的伺服器,讓研究人員能夠立即使用容器、預先訓練的模型和SDK,模擬應用成果,加速移轉到大規模部署的真實應用。

應用領域

高速運算&人工智能

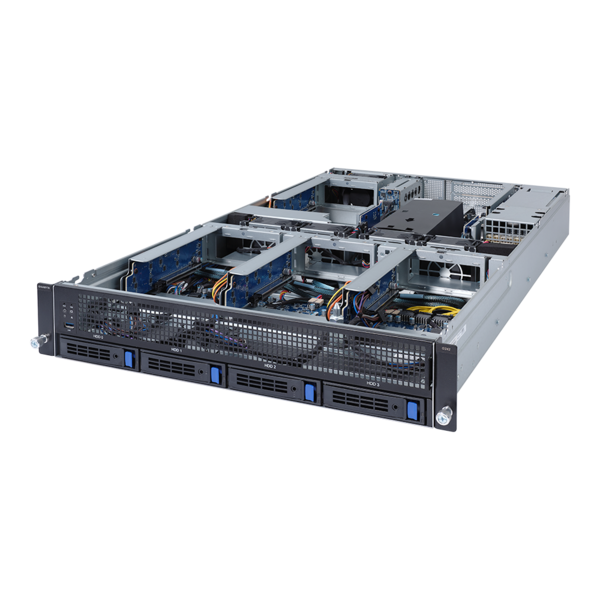

高速運算、儲存和網路基礎設施為AI應用奠定了基礎,從而提供精準可靠的模型。針對不同的HPC或AI工作負載,技嘉科技G系列伺服器搭配NVIDIA A100 Tensor核心GPU能支援各種精度運算,從而提高使用者效益。

工程與科學運算

大數據分析與科學模擬是工程師和資料科學家的共同需求。高效能運算伺服器所建構虛擬化環境,提供高效能平行運算兼具低延遲和高頻寬優勢,有助於提升工程師和科學家的科學模擬和研究工作。

雲端&高速運算

地端高速運算市場持續增長,而雲端架構的HPC叢集成長速度更快。用戶端正逐漸地將運算服務遷移到雲端架構來享受快速的運算資源分派並支付相應的成本。雲端HPC能讓使用者獲得最佳的軟硬體技術與維護支援。

NVIDIA A100 – 精緻工藝技術

NVIDIA A100運用NVIDIA Ampere架構的優化設計來同時滿足AI和HPC運算需求。A100採用台積電的7奈米FinFET製程提升顯著的電晶體密度、性能和效率,伴隨著創新的MIG技術,A100能為雲端服務供應商構建更加靈敏與彈性的GPU資源分配。

- NVIDIA Ampere架構:

新的Ampere架構包括了MIG技術,能將A100 GPU劃分為多個獨立運算的個體,又或者容許多張GPU透過NVLink串連來加速大規模工作負載運算,NVIDIA A100能彈性處理不同規模的加速運算需求,從最小的工作到多節點工作負載,使用A100 GPU能讓用戶全天候最大限度地發揮資料中心中每個GPU的資源。 - 第三代Tensor核心:

NVIDIA A100具備了312 TFLOPS的深度學習運算效能,與上一代Volta GPU相比,用於深度學習訓練的每秒浮點運算 (Floating-point Operations Per Second) 與TOPS效能 (Tera Operations Per Second) 提升高達20倍。 - 新一代NVLink:

NVIDIA NVLink與A100能提供2倍於上一代產品的傳輸力。搭配NVIDIA NVSwitch™運用時,更能以每秒600GB的速度串聯16張的A100 GPU,得以在搭載A100的技嘉伺服器上釋放出最高的運算力。NVLink技術同時支援SXM 以及PCIe介面的A100 GPU。 - 多執行個體GPU (MIG):

一張A100 GPU最多可以被劃分為七個獨立的GPU個體,每個個體的運算資源完全隔離具備專屬的高頻寬記憶體、快取和運算核心。MIG技術讓開發人員能突破資源瓶頸獲取突破性的加速效能,IT管理人員也得以為不同的運算需求提供最適當的GPU資源來提供服務與資源利用率的最佳化。 - 高頻寬記憶體 (HBM2e):

A100 GPU擁有80GB的高頻寬記憶體能提供目前市場最高每秒2TB的記憶體傳輸頻寬,讓動態隨機存取記憶體的使用效率達到95%。新一代NVIDIA A100提供比上一代GPU高達1.7倍的記憶體傳輸能力。 - 加速結構稀疏處理:

人工智慧模型透過深度神經網路 (DNN) 或卷積神經網路 (CNN) 等各式各樣網絡所構成,每種網絡都包含了數百萬到數十億個參數,並非所有參數都是準確預測所必需的,有些參數可以在演算過程中將值視作為零,這將使得人工智慧模型初建立時,雖然“結構稀疏”但不影響其預測的準確性。NVIDIA A100內建的Tensor核心能為稀疏模型運算提高2倍的性能,讓稀疏模型應用能更有效加速推論模型演算,增進整體效能。

專為HPC和資料科學而設計的HGX A100伺服器

推動效能極限的GPU加速運算發動機

專為HPC和資料科學而設計的HGX A100伺服器- 推動效能極限的GPU加速運算發動機

快速傳輸

整合NVLink、NVSwitch以及InfiniBand等網路高速傳輸特性,讓NVIDIA A100實現GPU-GPU和CPU-GPU的高速通訊。A100提供最高達每秒2,039GB的傳輸速度。

NVIDIA AI Enterprise提供人工智慧與資料分析軟體端對端的雲端原生套件,透過安裝NVIDIA HPC SDK,用戶可隨即找到適用於HPC或AI環境的佈署工具,加速軟硬體的佈署、啟動和運作。

| A100 80GB PCIe | A100 40GB SXM | A100 80GB SXM | |

|---|---|---|---|

| FP64 | 9.7 TFLOPS | ||

| FP64 Tensor Core | 19.5 TFLOPS | ||

| FP32 | 19.5 TFLOPS | ||

| Tensor Float 32 (TF32) | 156 TFLOPS | 312 TFLOPS* | ||

| BFLOAT16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | ||

| FP16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | ||

| INT8 Tensor Core | 624 TOPS | 1248 TOPS* | ||

| GPU Memory | 80GB HBM2e | 40GB HBM2 | 80GB HBM2e |

| GPU Memory Bandwidth | 1,935GB/s | 1,555GB/s | 2,039GB/s |

| Max Thermal Design Power (TDP) | 300W | 400W | 400W |

| Multi-Instance GPU | Up to 7 MIGs @ 10GB | Up to 7 MIGs @ 5GB | Up to 7 MIGs @ 10GB |

| Form Factor | PCIe | SXM | |

| Interconnect | NVIDIA® NVLink® Bridge for 2 GPUs: 600GB/s ** PCIe Gen4: 64GB/s |

NVLink: 600GB/s PCIe Gen4: 64GB/s |

|

| Server Options | Partner and NVIDIA-Certified Systems™ with 1-8 GPUs | NVIDIA HGX™ A100-Partner and NVIDIA-Certified Systems with 4,8, or 16 GPUs NVIDIA DGX™ A100 with 8 GPUs |

|

* With sparsity

** SXM4 GPUs via HGX A100 server boards; PCIe GPUs via NVLink Bridge for up to two GPUs

NVIDIA原廠認證系統

NVIDIA攜手技嘉為確保伺服器與GPU能一起順暢運作所推出的認證系統計劃。NVIDIA認證系統確認了搭載NVIDIA Ampere或TuringGPU的伺服器其軟硬體條是最佳化和工作相容性以確保用戶在使用時的企業級支援。NVIDIA認證系統含蓋了認證伺服器與NGC-Ready伺服器驗證計畫。

認證伺服器 – 經過NVIDIA GPU認證的伺服器在散熱、機械、電源和訊號設計上能確保GPU在伺服器中正常運作。

NGC-Ready伺服器 - 通過認證伺服器的伺服器搭配特定NVIDIA GPU組成,通過一套大規模測試,驗證其能為NGC容器提供高效能的服務與運算。

目前所規範的GPU為下列一個或多個的NVIDIA V100 Tensor核心、T4 Tensor核心或RTX 6000/ 8000 GPU。透過完整的組態與詳細的資料,我們提供用戶方便選擇組態的清單來簡化整個購買流程。NVIDIA與技嘉皆能為我們的客戶提供不同層級的企業支援,讓用戶能放心地部署應用程式。

支援NVIDIA A100 GPU的伺服器

5/6